Cross-Dataset Representation Learning for Unsupervised Deep Clustering in Human Activity Recognition

Authors: Tomoya Takatsu; Tessai Hayama; Hu Cui

https://ieeexplore.ieee.org/document/10971938

Abstract:

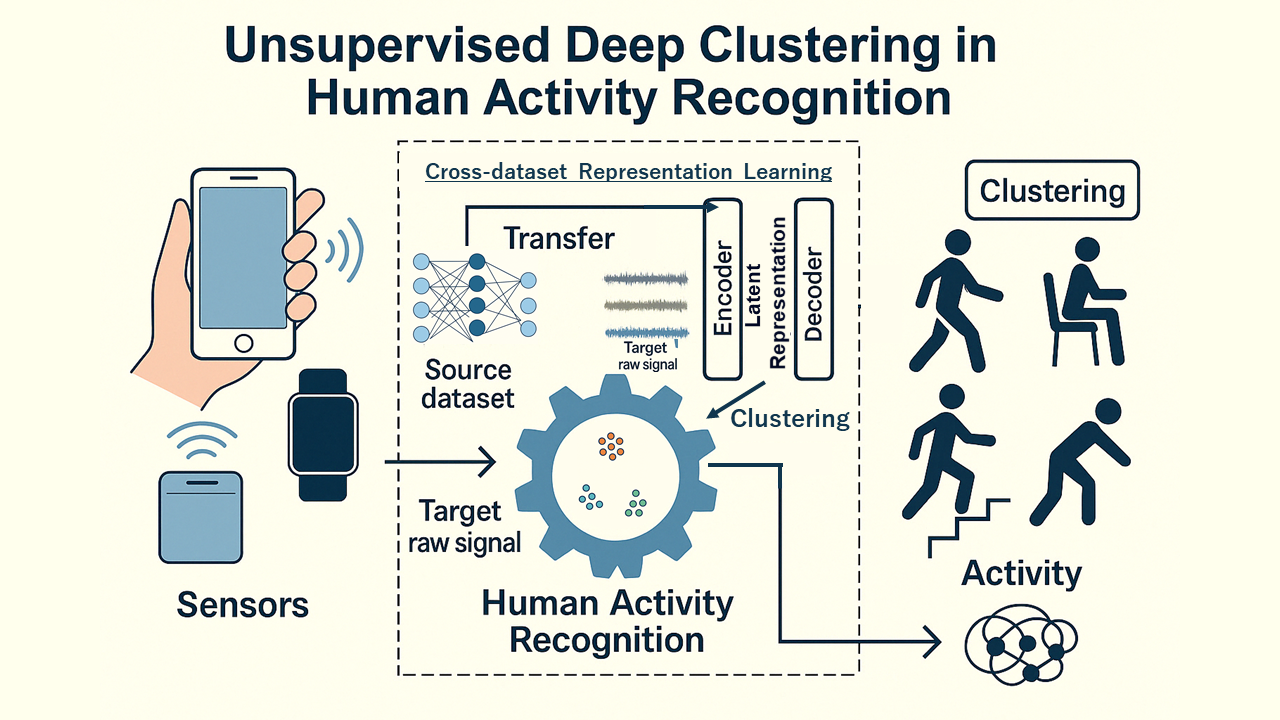

This study presents a new method to improve unsupervised deep clustering for Human Activity Recognition (HAR). Traditional methods often struggle to extract meaningful features from unlabeled data, resulting in poor classification accuracy. To solve this, the proposed method combines an autoencoder with models pre-trained on diverse HAR datasets. This approach helps extract more reliable and generalizable feature representations, which are then used for clustering.

The method was tested on three HAR datasets and significantly outperformed existing methods like k-means, HMM, and standard autoencoder-based clustering, achieving F1 scores between 0.441 and 0.781. Even with just 50 labeled samples for fine-tuning, the performance improved further, reaching F1 scores of 0.66 to 0.88. This demonstrates the method’s robustness and effectiveness in unsupervised settings. It also shows promise for broader use beyond HAR.

本研究は、人間行動認識(HAR)における教師なし深層クラスタリングの精度を向上させる新しい手法を提案しています。従来の手法では、ラベルなしデータから有用な特徴をうまく取り出せず、分類性能が低いという課題がありました。

そこで本研究では、さまざまなHARデータセットで事前学習されたモデルとオートエンコーダを組み合わせることで、より頑健で汎用的な特徴表現を抽出し、それを使ってクラスタリングを行います。

3つのHARデータセットで検証した結果、従来手法(k-meansやHMM、通常のオートエンコーダ)よりも高いF1スコア(0.441〜0.781)を達成。さらに、わずか50個のラベル付きデータで微調整した場合でもF1スコアが0.66〜0.88まで向上しました。

この手法は、ラベルの少ない状況でも高い認識精度を実現できることを示しており、HAR以外の分野にも応用可能な、実用性と拡張性の高い方法です。